Jeżeli modele sztucznej inteligencji nie są wyjaśnialne, to specjaliści (np. w medycynie) muszą w pełni zaufać technologii, mimo że to oni podpisują się pod diagnozą. W naszym laboratorium opracowujemy system, który będzie potrafił odpowiedzieć, co jest podstawą jego predykcji. Z Piotrem Sobeckim, kierownikiem zespołu Laboratorium Stosowanej Sztucznej Inteligencji OPI PIB, rozmawia Monika Redzisz

Monika Redzisz: Czym zajmuje się zespół Laboratorium Stosowanej Sztucznej Inteligencji OPI PIB*?

Piotr Sobecki**: Między innymi zastosowaniem SI w medycynie. Zajmujemy się standaryzacją badań, analizą obrazu i tworzeniem modeli sztucznej inteligencji do wspomagania diagnostyki. Analizujemy na przykład problem diagnostyki nowotworu prostaty z użyciem rezonansu magnetycznego. Jest to drugi najczęściej występujący nowotwór u mężczyzn – szacuje się, że w trakcie swojego życia zachoruje na niego co szósty mężczyzna. Niestety, jego diagnoza jest skomplikowana.

Dlaczego?

Z kilku powodów. Testem przesiewowym w przypadku badań prostaty jest pomiar poziomu PSA we krwi, czyli pewnego enzymu. Jego wysoki poziom świadczy o tym, że występuje jakaś nieprawidłowość. W takim wypadku wymagana jest dalsza diagnostyka. Radiolog na podstawie analizy zdjęć z rezonansu magnetycznego musi zdecydować, czy zmiana wygląda na złośliwą, a od tego będą zależały kolejne decyzje, na przykład czy należy wykonać biopsję. Biopsja w przypadku badania prostaty nie jest łatwa ani komfortowa dla pacjenta. Polega na pobraniu materiału do badania z kilku do kilkunastu wkłuć wykonanych w czasie badania.

Gdy na podstawie obrazów z rezonansu będziemy mieć dostatecznie precyzyjne metody oceny zmian, będziemy mogli znacznie ograniczyć liczbę pacjentów, którzy są wysyłani na biopsję.

Na jakim etapie są prace?

Tworzymy narzędzia wspomagające ten proces. Jednym z nich jest głęboka sieć neuronowa, która na podstawie zdjęć prostaty z rezonansu szacuje prawdopodobieństwo, że określona zmiana jest złośliwa. Jej skuteczność szacowana jest na około 85 procent, co jest zbliżone do skuteczności radiologa. Algorytm ocenia istotność wykrytej zmiany w skali procentowej (przykładowo 10, 60, 80 procent). Jest to analogiczne do skali PI-RADS, której używają specjaliści.

A co, kiedy okazuje się, że zmiana jest złośliwa na 60 procent? Co robi z tym radiolog?

Właśnie. Żeby to zrozumieć, musimy zrobić krok wstecz, czyli określić, na czym polega praca diagnosty. Wyobraźmy sobie sytuację, gdy czyścimy skrzynkę mailową i oceniamy maile w skali spam/nie spam. Sami zrobimy to od razu, na wyczucie. Mając system do takiej klasyfikacji, dostajemy informację, że dany mail jest według niego spamem na 60 procent. To skrajnie uproszczony opis pracy diagnosty.

Dostał wynik z jakiejś maszynki: 60 procent. Ale dlaczego akurat 60? Tego nie wie. Jak ma wykorzystać tę informację? 60 procent prawdopodobieństwa to mało, w zasadzie to nic nie mówi, ponieważ jest zbliżone do losowej decyzji. Ale nawet jeśli to będzie – powiedzmy – 80 procent, to lekarz też ma problem, bo brakuje mu informacji, dlaczego sztuczna inteligencja podjęła taką właśnie decyzję.

Potrzebujemy dużo danych, tymczasem największy publicznie dostępny otwarty zbiór danych w obszarze obrazowania prostaty liczy zaledwie 350 przypadków

Obecnie to największe wyzwanie dla naukowców zajmujących się sztuczną inteligencją: jak tworzyć wyjaśnialne modele niebędące czarnymi skrzynkami, czyli takie, które są w stanie odpowiedzieć, co jest podstawą predykcji systemu.

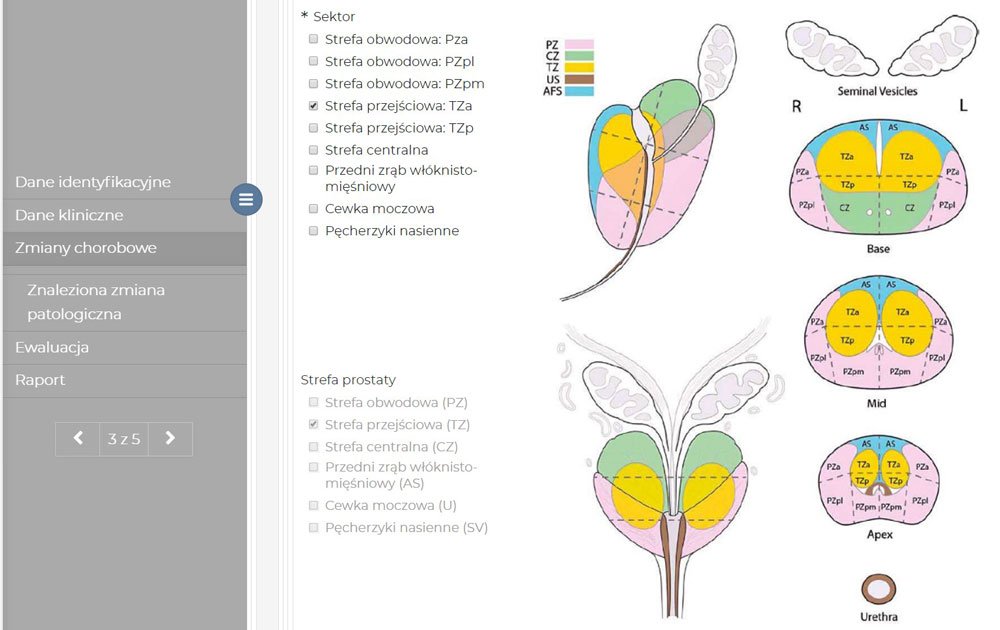

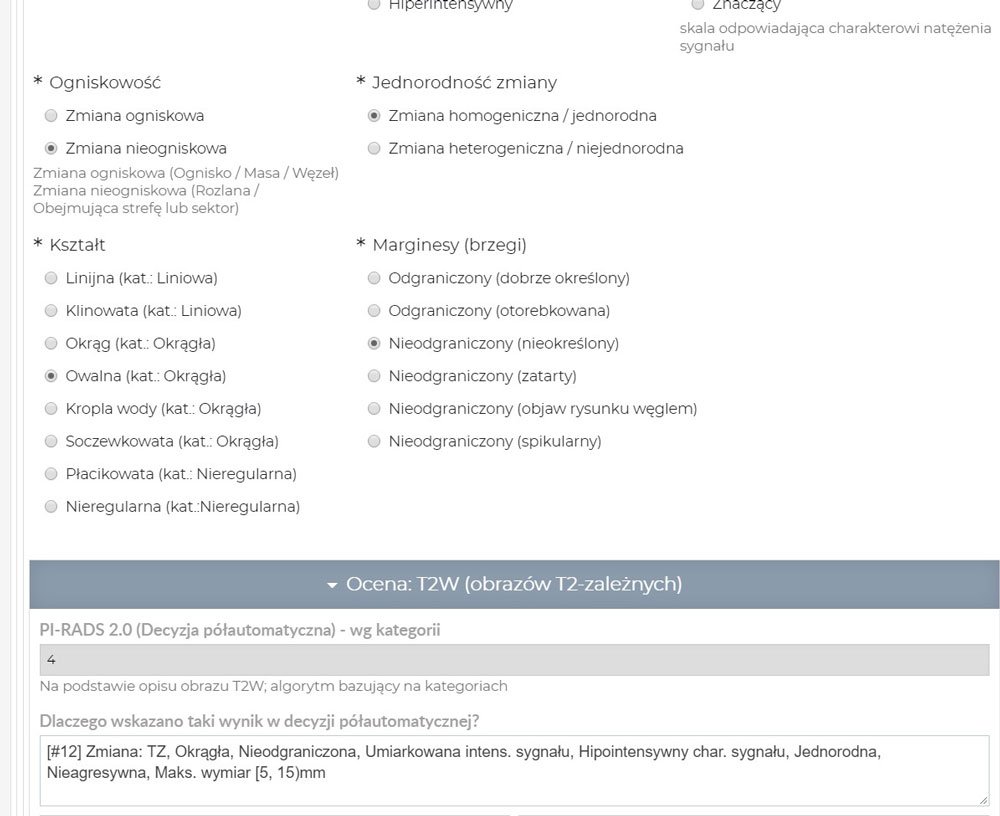

W naszym laboratorium opracowujemy system wspomagany sztuczną inteligencją (eRADS), który będzie to potrafił. Określiliśmy już ponad 100 parametrów, których część przełożyliśmy na tabele decyzyjne. W docelowej wersji narzędzia będzie wyglądało to tak: najpierw system dokona automatycznej analizy obrazów medycznych. Lekarz otrzymuje do oceny wygenerowany wynik badania w standardzie PI-RADS. Jego zadaniem jest weryfikacja opisu badania. Obecnie taki opis w postaci tekstu musi napisać ręcznie, co wydłuża diagnostykę i zawęża zakres badania.

Jeśli na którymś z etapów lekarz ma wątpliwości co do automatycznie wygenerowanego opisu, może zobaczyć, skąd wziął się taki wynik – zobaczyć, jakie zmienne pośrednie były tu szacowane, i dowolnie je modyfikować. Może na przykład zobaczyć, że algorytm w jednym punkcie stwierdził, że znaleziona zmiana jest średnio hipointensywna, gdy tymczasem jego zdaniem jest znacząco hipointensywna. Będzie miał do dyspozycji ponad 100 oszacowanych parametrów, a jednocześnie – pełną kontrolę nad nimi.

Wejście do czarnej skrzynki…

Tak. Jeżeli modele nie są wyjaśnialne, to specjaliści muszą w pełni zaufać technologii, mimo że na samym końcu to oni podpisują się pod diagnozą. Oczywiście ludzie wprowadzają metody hybrydowe. Przykładowo algorytmy zaznaczają kolorem obszary zmian, tak żeby w zależności od zabarwienia łatwiej było je oceniać. Wtedy kolor może sugerować prawdopodobieństwo, że dana zmiana jest złośliwa. To faktycznie pomaga specjaliście określić, co może wpływać na predykcje modeli.

Skąd bierzecie dane do trenowania algorytmu?

No właśnie, z tym jest problem. Potrzebujemy dużo danych, tymczasem największy publicznie dostępny otwarty zbiór danych w obszarze obrazowania prostaty liczy zaledwie 350 przypadków.

Żeby wytrenować modele, musieliśmy sztucznie powiększyć zbiór danych – wprowadzić pewne zniekształcenia, zaszumienia obrazu. To bardzo częsta praktyka w sytuacji, kiedy brakuje danych do trenowania SI. Nasze sieci mają kilka milionów parametrów, a do dyspozycji – jedynie 350 przypadków. Sieć jest w stanie nauczyć się na pamięć każdego piksela. Rozszerzanie powoduje, że sieć nie będzie zwracała uwagi na szczegóły, które identyfikują konkretny przypadek, a nie są istotne dla modelowanej problematyki.

Modele sztucznej inteligencji są tak dobre, jak dane, na których zostały wyuczone. Chodzi zarówno o ich liczebność, czyli ile przypadków jest w danym zbiorze, jak i o jakość.

Nie ma możliwości współpracy ze szpitalami?

Współpracujemy merytorycznie z zakładem radiologii w Centrum Medycznym Kształcenia Podyplomowego w Warszawie. Problem jest taki, że oddziały mają zwykle same dane obrazowe i ich opisy. Przychodzi pacjent, robi sobie rezonans, dostaje wynik i idzie w świat. Nie mamy informacji zwrotnej, co się z nim potem działo. Pacjenci pojawiają się i odchodzą, a my mamy problem, żeby zintegrować obrazy i ich opisy z dalszą sytuacją zdrowotną (np. wynikami biopsji). Co więcej, mimo że od kilku lat istnieje światowy standard opisu radiologicznego PI-RADS (Prostate Imaging and Reporting and Data System), to w zasadzie każdy lekarz ma swój sposób zapisywania tych informacji. Opisy w tej postaci trudno przełożyć na zbiór danych dla sztucznej inteligencji.

To daje spory margines subiektywności…

Tak. Diagnosta określa przecież cechy znalezionych zmian. Czy zmiana jest homogeniczna, czy heterogeniczna? Jednorodna czy nie? Każdy lekarz ma swoje poczucie tej jednorodności; jeden oznaczy, że jest jednorodna, drugi, że nie. Albo: jak subiektywnie określić nasycenie koloru? Czy jest słabo, umiarkowanie czy znacznie hipointensywne? Średnio ciemne czy bardzo ciemne? A przecież od tego zależy decyzja o diagnozie. Oczywiście czasem sprawa jest ewidentna i nie ma się nad czym zastanawiać. Ale wszystko, co jest pomiędzy, to obszar do dyskusji.

My proponujemy nasze autorskie rozwiązanie tego problemu: przygotowaliśmy specjalne narzędzie dla radiologów. Zadaniem lekarza będzie określanie cech na zdefiniowanym formularzu zamiast ręcznego tworzenia opisu. W trakcie jego pracy powstają wysokiej jakości zbiory danych, które mogą posłużyć do badań nad standardami oceny zmian nowotworowych. Dzięki takiemu podejściu otrzymujemy także piękną bazę danych do uczenia algorytmów sztucznej inteligencji, a na podstawie wypełnionego formularza automatycznie generowany jest opis badania.

Właśnie zaczęliśmy prace. Zbieramy opisy 30 przypadków wykonywane przez sześciu radiologów, trzech niedoświadczonych i trzech doświadczonych. Po miesiącu – powtórka. To interesujące także z psychologicznego punktu widzenia; będziemy zresztą prowadzili te badania we współpracy z psychologami poznawczymi z SWPS. Czy wyjdą duże różnice pomiędzy radiologami? Czy po miesiącu lekarz tak samo oceni badanie jak za pierwszym razem? Jestem bardzo ciekawy, co z tego wyniknie. Moje doświadczenie oprócz informatyki obejmuje również psychologię. Jeszcze na studiach pracowałem nad narzędziem do badania podatności na iluzje optyczne (VIS – Visual Illusion Simulation), bo wszyscy rodzimy się z większą lub mniejszą podatnością. I teraz pytanie: jak podatni na iluzje są radiolodzy?

Gdy na podstawie obrazów z rezonansu będziemy mieć dostatecznie precyzyjne metody oceny zmian, będziemy mogli znacznie ograniczyć liczbę pacjentów, którzy są wysyłani na biopsję

Jak czują się śmiałkowie, którzy zgłosili się do projektu? Boją się?

Możliwe. Ludzie niezbyt lubią dowiadywać się, że mogą się mylić. Jednak zdają sobie sprawę, że system będzie dla radiologów wsparciem.

Ale jednocześnie zagrożeniem. Czy ta metoda nie pozbawi ich wkrótce pracy? A przynajmniej – czy polegając na maszynie, nie stracą swojej autonomii oraz wyczucia?

Myślę, że będzie zupełnie inaczej. Radiologów brakuje. Rezonanse mogą pracować 24 godziny na dobę, ale kto je opisze? Nie ma tylu specjalistów. System bardzo ułatwi im pracę. Będą mogli opisać więcej badań w tym samym czasie, a komfort ich pracy i jakość ich badań wzrośnie. To także narzędzie edukacyjne. Młodzi specjaliści mogą się z jego pomocą uczyć, jak prawidłowo oceniać zmiany.

Czy widać różnicę pokoleniową w podejściu do takich metod?

Pewnie. Badania pokazują, że doświadczeni specjaliści często uważają: „Przecież wiem, co robię. Robię to tyle lat. Znam swoją skuteczność. Po co mi jakaś maszynka, która będzie mi mówiła, co mam robić?”. Młodsi – wręcz przeciwnie – są otwarci na wprowadzanie takich rozwiązań.

Niestety, 30 przypadków to dość mało. Gdybyśmy mieli 500, to już by było coś. Ale taki zbiór danych kosztuje. Dlatego złożyliśmy właśnie wniosek grantowy do NCN-u [Narodowego Centrum Nauki] na współpracę ze Szpitalem Uniwersyteckim w Oslo. W ramach współpracy zintegrowane zostałyby zbiory danych z polskich i norweskich ośrodków zawierające adnotacje z opracowanego narzędzia. To byłby największy i najdokładniej opisany otwarty zbiór danych mpMRI prostaty, jaki istnieje na świecie.

Najbardziej cieszy mnie to, że schemat, który sobie teraz wypracujemy dla diagnostyki w kierunku rozpoznania raka prostaty, będzie świetną podstawą do pracy nad kolejnymi chorobami.

*OPI PIB – Ośrodek Przetwarzania Informacji – Państwowy Instytut Badawczy jest wydawcą portalu Sztuczna Inteligencja

**Piotr Sobecki – kierownik Laboratorium Stosowanej Sztucznej Inteligencji w OPI PIB. Doktorant informatyki (Politechnika Warszawska, Wydział Matematyki i Nauk Informacyjnych), magister informatyki (Polsko-Japońska Akademia Technik Komputerowych) i psychologii (SWPS Uniwersytet Humanistycznospołeczny). W 2018 roku jeden z ekspertów przygotowujących założenia do strategii rozwoju sztucznej inteligencji w Polsce. Jego zainteresowania naukowe to informatyka medyczna, uczenie głębokie, komputerowe rozpoznawanie obrazów, przetwarzanie sygnałów oraz psychologia kognitywna.

Read the English version of this text HERE