Janusz Żmudziński: Tak naprawdę nie wiemy, kim są ludzie, którzy przechodzą darmowe kursy sztucznej inteligencji. Nie wiemy, skąd oni są, ani jaki jest cel ich nauki

Mamy kilka podstawowych obszarów cyberbezpieczeństwa, w których wykorzystywane są uczenie maszynowe (ML) i uczenie głębokie (DL). Pierwszy to przewidywanie zagrożeń, poza tym mamy reagowanie na incydenty, analizę oprogramowania złośliwego, klasyfikację treści i dokumentów.

Jak przestępcy wykorzystują SI?

Nie ma tu prostej i jednoznacznej odpowiedzi. Weźmy na przykład takie złośliwe oprogramowanie DeepLocker, które nie jest rozpoznawane przez istniejące systemy zabezpieczające. W tej chwili do ataków w środowiskach produkcyjnych, w których używano by takiego oprogramowania, prawdopodobnie nie dochodzi. Prawdopodobnie, bo to wcale nie jest oczywiste.

Poza tym cyberprzestępcy mogą wykorzystywać sztuczną inteligencję do ataków na inną sztuczną inteligencję.

Czy to łatwe?

Istotne jest to, że z punktu widzenia cyberprzestępców mamy do czynienia z niską barierą wejścia. Innymi słowy, istnieje wiele ogólnodostępnych narzędzi typu open source oraz ogromna dokumentacja pozwalająca się tego wszystkiego nauczyć. Mamy studia, łącznie ze ścieżkami uniwersyteckimi z obszaru sztucznej inteligencji, mamy kursy, które można ukończyć zdalnie – na przykład podstawowy kurs uczenia maszynowego prowadzony przez Andrew Nga na Uniwersytecie Stanforda. W ciągu ostatnich kilku lat ukończyło go ponad 100 tys. ludzi. Tak naprawdę nie wiemy, kim ci ludzie są, skąd oni są, jaki mają cel tej nauki. Dostęp do wiedzy jest szeroki i bardzo łatwy.

Czy to kosztowne?

Budowanie systemów sztucznej inteligencji, zwłaszcza opartych o głębokie uczenie, nie musi być kosztowne. Częściowo to prawda, że w systemach cloudowych bez problemu można na godziny, na dni czy na miesiące wynająć oprogramowanie pracujące na bardzo zaawansowanych platformach. Przy małej ilości danych można wykorzystać oprogramowanie dostępne za darmo. Są liczne narzędzia typu open source, podstawowe biblioteki, które służą do budowania systemów sztucznej inteligencji, takie jak TensorFlow, Keras, Pytorch, dostępne za darmo. Mogą z nich korzystać zarówno twórcy oprogramowania, które będzie wykorzystywane do pozytywnych celów, jak cyberprzestępcy.

Czy manipulacja danymi to poważne zagrożenie?

Tak. Badania pokazują, że wystarczy niewielkie zakłócenie w danych wejściowych, a system wykorzystujący mechanizmy ML i DL może popełnić kardynalne błędy. Na przykład systemy rozpoznawania obrazów są bardzo często wykorzystywane przez różne rozwiązania związane z bezpieczeństwem. Wystarczy drobna manipulacja, dodanie do obrazka jakiegoś zakłócenia, zmiana balansu bieli, szum – by ten system mógł zawieść. Na przykład na obrazku mamy ciężarówkę, budowlę albo jakieś zwierzę, a po wprowadzeniu zakłóceń system, który analizuje dane wejściowe, za każdym razem będzie widział, dajmy na to, strusia. Myślimy dziś o samochodach autonomicznych. Co będzie, jeśli nie będą one prawidłowo rozpoznawały znaków drogowych? Eksperymenty pokazały, że jeśli zmodyfikować znak drogowy, nanosząc na niego kilka nalepek albo graffiti, zostaje on rozpoznany jako zupełnie inny, a samochód sterowany z wykorzystaniem takiego oprogramowania zachowuje się niezgodnie z przepisami ruchu drogowego. Łatwo sobie wyobrazić potencjalne konsekwencje.

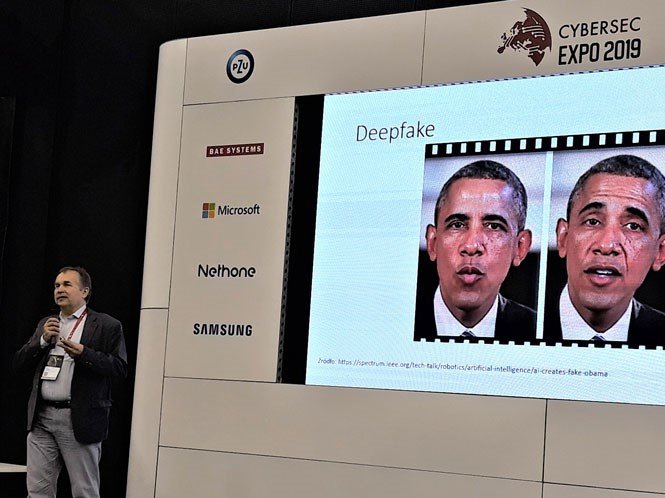

Czy trzeba się bać deepfake’ów?

Filmy i nagrania audio, które służą do generowania fałszywych przekazów, są zagrożeniem jeszcze mało widocznym, ale ono będzie narastało. Do niedawna wyprodukowanie takiego filmu czy materiału audio wymagało ogromnych mocy; można było to zrobić korzystając z technik filmowych. Od niedawna można to robić w zaciszu domowym, korzystając z laptopa. I nawet wytworzone na tym poziomie jest bardzo trudne do weryfikowania. Szacuje się, że tego typu nagrania, zwłaszcza stosowane w walce politycznej, będą stanowiły coraz większe zagrożenie. A metody wykrywania ich będą miały coraz większe znaczenie.

Jakie to ma przełożenie na obronność?

Dobrą ilustracją kwestii wykorzystania systemu sztucznej inteligencji do systemów uzbrojenia i zagrożeń z tym związanych jest na przykład program Skyborg.

W Stanach Zjednoczonych trwają prace nad systemem autonomicznych samolotów bojowych, które mogą trafić do użytku już w roku 2021 lub 2022. Jednym z głównych elementów takiego samolotu będzie sztuczna inteligencja. Pojawia się pytanie, czy oprogramowanie nie będzie się myliło, czy będzie w stanie wykrywać właściwe cele, czy będzie odporne na próby manipulowania nim z ziemi. Przecież Chińczycy już dziś fałszują zdjęcia satelitarne, wykorzystując do tego technologie deepfake.

Kto wytycza kierunki w wyścigu do SI?

W 2017 roku władze chińskie stwierdziły, że do roku 2030 chcą zostać liderem na rynku sztucznej inteligencji, a najlepsze rozwiązania w tej dziedzinie mają być rozwiązaniami chińskimi. W tym samym okresie Władimir Putin powiedział, że w przyszłości światem będzie rządził ten, kto będzie najlepszy w SI. I Rosjanie teraz nad tym intensywnie pracują. Od kilku lat trwa bardzo ostra rywalizacja między Chinami a Stanami. Prawdopodobnie liczba chińskich publikacji dotyczących sztucznej inteligencji w ubiegłym roku przekroczyła liczbę publikacji amerykańskich.

W którym państwie SI najbardziej inwigiluje obywateli?

Oczywiście w Chinach. W 2014 r. władze tego państwa postanowiły zbudować system śledzący tak potężny, że podobne pomysły znaliśmy wcześniej tylko z książek i filmów. Dziś ten system, zwany systemem kredytu społecznego, staje się w Chinach elementem codziennego życia. Za jego pomocą tworzony jest w tym kraju ranking obejmujący wszystkich obywateli, czyli prawie 1,4 mld ludzi, i ogromnej liczby firm, zwłaszcza małych i średnich. W tym rankingu są cztery kategorie: A, B, C, D. W przypadku ludzi pierwsza obejmuje tych, którzy cieszą się największym zaufaniem władzy. Tacy mogą liczyć na najlepsze traktowanie – na przykład awanse, pełną swobodę podróżowania, lepszą płacę i pracę. A firmy z kategorii A są nagradzane np. lepszymi warunkami projektowymi. Z kolei najniższa kategoria D grupuje osoby, które podpadły władzy, więc nie uzyskają kredytów, będą miały problemy z awansem pracy, poruszaniem się po kraju i wyjazdami za granicę. A dzieci takich ludzi będą miały problemy z dostaniem się na studia.

W maju 2019 r. Chińczycy podali informację, że w ciągu roku od próbnego uruchomienia systemu z powodu niskiej pozycji w rankingu społecznym części objętych nim osób anulowano około 23 mln transakcji związanych z zakupem biletów (ok. 17 mln transakcji dotyczyło biletów lotniczych, a ok. 5 mln biletów kolejowych). Można być ukaranym za różne rzeczy, nie tylko krytykowanie władzy, ale też na przykład za rzucanie niedopałka na ulicy, palenie w miejscu niedozwolonym, wyprowadzanie psa bez smyczy, hałasowanie, długie granie w internecie. Można też jednak „odkupić” swoje przewiny, podnieść pozycję w rankingu. Na przykład donosząc na kogoś.

Po co to Chińczykom?

Z naszego punktu widzenia celem jest permanentna inwigilacja. Ale sami Chińczycy tego tak nie odbierają, nie burzą się przeciwko systemowi, mimo że wiąże się on z istotną ingerencją w ich prywatność, ograniczeniem ich swobód, a dane o ludziach są gromadzone z bardzo wielu źródeł bez ich wiedzy. https://www.sztucznainteligencja.org.pl/soros-si-w-rekach-rezimu-jest-niebezpieczna/ Chińczycy godzą się na to, bo uważają, że system hierarchiczny jest właściwy, a dobro ogółu liczy się bardziej niż dobro jednostki.

Czy ten system może się pomylić?

Oczywiście. Głośny był swego czasu przypadek chińskiego dziennikarza, który został ukarany, karę zapłacił, natomiast ta sprawa nadal się za nim ciągnęła. Wyjście z systemu kar nie jest takie proste.

Kolejnym po Chinach krajem, który próbuje coś takiego wdrożyć, jest Australia – państwo demokratyczne o zachodnich standardach obywatelskich i kulturowych. Australijskie miasto Darwin postanowiło kupić od Chińczyków co najmniej część stworzonego przez nich rozwiązania.

Jednym z ważnych elementów tego systemu jest monitoring zbudowany przez firmę SenseTime Group, największy chiński start-up związany ze sztuczną inteligencją. W czasie rzeczywistym system przeprowadza analizę, rozpoznaje obrazy, identyfikuje twarze ludzi – i robi to na ogromną skalę, prawdopodobnie gromadząc i przetwarzając obrazy nie tylko wykonane w Chinach. To poważne zagrożenie także dla naszej prywatności.

Ktoś jeszcze korzysta z rozwiązań tego start-upu?

Honda, która wprowadza systemy analizy obrazu i analizy ruchu do autonomicznych pojazdów. Ponadto szacuje się, że oprogramowanie pochodzące z SenseTime Group ma wbudowane ponad 100 mln telefonów na świecie.

Inne budzące obawy o naruszenie prywatności oprogramowanie ze sztuczną inteligencją to system Viper, który potrafi przetwarzać dane przesyłane na żywo z ogromnej liczby kamer do jednego, centralnego systemu. Filmy są analizowane na żywo, online. Stosowane tu oprogramowanie miewa jeszcze pewne problemy z analizą obrazów, a założenie okularów może spowodować, że system nie rozpozna człowieka.

Natomiast inna chińska firma, Watrix, opracowała oprogramowanie, które identyfikuje ludzi na podstawie analizy ich chodu i postawy w ruchu. W takim przypadku nawet zakrycie twarzy nie pozwala na uniknięcie identyfikacji.

Janusz Żmudziński – ekspert w dziedzinie bezpieczeństwa teleinformatycznego. W ostatnich kilkunastu latach zajmował się architekturą bezpieczeństwa IT w czołowych polskich firmach informatycznych: Prokom Software SA, Asseco Poland SA. i Asseco Data Systems SA. Od wielu lat zajmuje się projektowaniem i wdrażaniem rozwiązań związanych z bezpieczeństwem informacji. Jest członkiem Polskiego Towarzystwa Informatycznego i ISACA.

** Tekst jest rozwinięciem wątków wykładu Janusza Żmudzińskiego o Sztucznej Inteligencji i cyberzagrożeniach w trakcie V edycji konferencji CYBERSEC CEE w Katowicach pod koniec października 2019 r.