Po pół wieku od chwili, gdy Alan Turing zaproponował swój słynny test, maszyny stały się bardzo dobre w udawaniu ludzi

W czasach gdy jeszcze nie było telewizji (o komputerach i internecie nie wspominając), popularną rozrywkę stanowiły gry i zabawy towarzyskie. Jedna z nich polegała na przekazywaniu karteczek z pytaniami ukrytej w innym pokoju osobie i próbie odgadnięcia jej płci na podstawie uzyskiwanych odpowiedzi.

Pionier informatyki Alan Turing w 1950 roku zaproponował podobny test: na podstawie uzyskiwanych odpowiedzi człowiek miał odgadnąć, czy rozmawia z innym człowiekiem, czy z maszyną. W pracy, którą na ten temat napisał i opublikował, sugerował, aby na konwersację z maszyną każdy z ludzkich „sędziów” miał pięć minut. Jeśli co najmniej jeden na trzech rozmówców będzie przekonany, że rozmawia z człowiekiem, taką maszynę należy uznać za inteligentną. Zaproponowany przez Turinga test był pierwszą próbą zdefiniowania tego, co możemy uważać za sztuczną inteligencję.

Eugene zdaje test

Sam Turing uważał, że uczenie maszynowe nabierze w przyszłości znaczenia, i był przekonany, że kiedyś maszyny taki test przejdą. Oceniał, że stanie się to „za około 50 lat”, gdy komputery osiągną pojemność pamięci około stu megabajtów. Co do czasu niewiele się pomylił.

W 2011 roku ponad połowa z niemal 1,5 tysiąca rozmówców powstałego 12 lat wcześniej CleverBota uznała program za człowieka. Fakt, 1,3 tysiąca osób biorących udział w teście mogło zadać tylko jedno lub dwa pytania – ale już trzy lata później, w 2014 roku, klasyczny test Turinga, czyli pięciominutową rozmowę, pomyślnie przeszedł chatbot Eugene.

W 1990 roku wynalazca Hugh Loebner zaproponował trudniejszą odmianę testu: rozmowa z maszyną ma trwać 25 minut, a sukcesem będzie przekonanie dwóch z czterech osób, że rozmawiają z człowiekiem. Najtrudniejszą odmianą testu jest ta wymyślona przez futurologa Raya Kurzweila. Z maszyną mają rozmawiać trzej sędziowie przez dwie godziny. Przekonani o rozmowie z człowiekiem mają zostać dwaj (w istocie warunek jest trochę bardziej skomplikowany – regulamin próby można przeczytać tutaj)

Zwodnicza sztuka udawania

Jak łatwo zauważyć, kolejne pomysły różnią się od oryginalnego testu Turinga tylko parametrami – wydłużaniem testowych rozmów i zwiększaniem liczby osób, które mają być przekonane, że rozmawiają z człowiekiem. Pomijając to, że czas na przekonanie ludzi można arbitralnie i dowolnie wydłużać – to czy na pewno tędy droga?

Jak się dowiemy, że sztuczna inteligencja jest inteligentna, jeśli nie będziemy mogli się z nią w zrozumiały dla nas sposób skomunikować?

Przy okazji wymyślania kolejnych testów na „człowieczeństwo” maszyn od dawna podnoszony jest argument „idealnej symulacji”, czyli tego, że nie posiadając jakiejkolwiek inteligencji, maszyna może doskonale naśladować ludzkie rozmowy i ludzki sposób argumentowania. Teoretycznie, mając do dyspozycji odpowiednio bogatą bazę odpowiedzi ludzi na pytania, można przedstawiać człowiekowi odpowiedzi nie tylko właściwe, ale wręcz przekonujące. Nie trzeba zatem wielkich zdolności przetwarzania danych ani zasobów, by skutecznie rozmowę symulować. Tym bardziej że udawało się to już wczesnym chatbotom, na długo przed zaliczeniem testu Turinga przez Eugene.

ELIZA, czyli (prawie) idealna symulacja

W 1966 roku Joseph Weizenbaum (informatyk, który przez wiele lat pracował nad sztuczną inteligencją, by później zostać jednym z jej czołowych krytyków) napisał prosty program mający imitować… psychoanalityka. W napisanym przez człowieka zdaniu wyodrębniał słowo kluczowe i zadawał pytanie na jego temat. Gdy człowiek zaczynał rozmowę na przykład od stwierdzenia: „Moja matka mnie denerwuje”, maszyna odpowiadała: „Opowiedz mi więcej o swojej matce”.

ELIZA (bo taką nosił nazwę program Weizenbauma) była na tyle skuteczna w udawaniu człowieka, że powstały żarty o naturze psychoterapii czy naturze ludzkich rozmów w ogóle. Skoro więc istnieją programy dobrze imitujące konwersację, być może powinniśmy zmodyfikować test Turinga tak, by nie skupiał się na zdolności do rozmowy?

Tym bardziej że skuteczna komunikacja nie musi być przecież wyznacznikiem inteligencji. Można sobie wyobrazić sytuację odwrotną, czyli inteligentny byt pozbawiony umiejętności rozmawiania (to zresztą częsty motyw w literaturze science fiction, na którym opiera się „Solaris” Stanisława Lema czy jego ostatnia powieść „Fiasko”).

Badacze sugerują, by zadawać sztucznej inteligencji coraz trudniejsze pytania odnoszące się do jej zdolności postrzegania własnego istnienia

Jak się dowiemy, że sztuczna inteligencja jest inteligentna, jeśli nie będziemy mogli się z nią w zrozumiały dla nas sposób skomunikować?

Co ty wiesz o umieraniu

W eseju opublikowanym na portalu Kurzweil Network dwoje badaczy, dr Susan Schneider i Edwin Turner, proponuje, by nie testować sprawności konwersacyjnych. Jedną z najbardziej wyrazistych cech ludzi jest przecież ich samoświadomość. Wszyscy bardzo szybko i sprawnie odnotowujemy odniesienia do nas samych.

Badacze sugerują więc, by zadawać sztucznej inteligencji coraz trudniejsze pytania odnoszące się do jej zdolności postrzegania własnego istnienia. Na początku można by zapytać, czy uważa się za coś więcej niż fizyczny byt – proponują. Potem sprawdzilibyśmy, jak radzi sobie z pojęciami takimi jak „życie”, „śmierć” czy „życie pozagrobowe”. Trudniejsze pytania mogłyby dotyczyć natury świadomości. Natomiast na najbardziej zaawansowanym etapie testu należałoby sprawdzić, czy sztuczna inteligencja sama, niezachęcona ani instruowana przez ludzi, takimi konceptami operuje. I czy wykazuje zachowania wskazujące na to, że tak jest w istocie (na przykład opłakuje zmarłych).

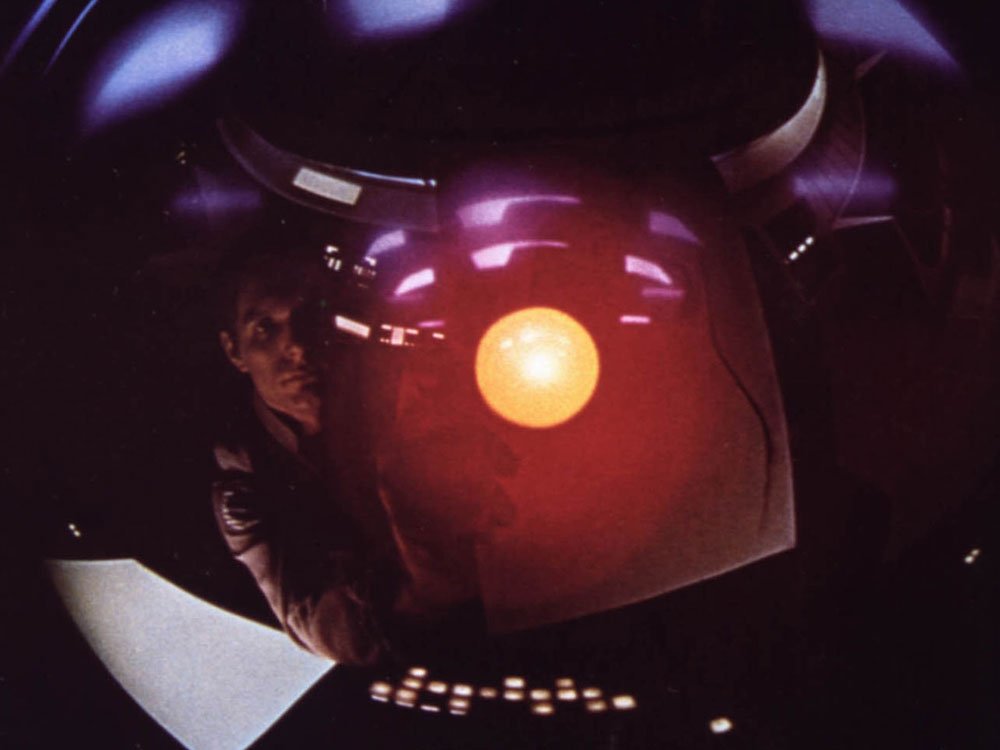

HAL 9000 prosi o życie

Autorzy przytaczają przykład komputera HAL 9000 z „Odysei kosmicznej” Stanleya Kubricka, który – zagrożony unicestwieniem – prosi o darowanie mu życia, więc bez wątpienia jest świadomym inteligentnym bytem. Nawiasem mówiąc, zmarłych opłakują też szympansy, orki, delfiny i krukowate, którym przypisuje się wysoko rozwiniętą inteligencję.

Naturalnie, można wytoczyć (co zresztą czynią autorzy eseju) kontrargument, że sztuczną inteligencję można by zaprogramować tak, by chroniła ciągłość własnego istnienia (co wystarczyłoby do wywołania „instynktu samozachowawczego”). Wystarczająco złożona maszyna mogłaby wydedukować też, że ludzie mają świadomość, na podstawie zasobów ludzkiej wiedzy. Wreszcie mogłaby też nauczyć się udawać, że świadomość posiada.

Jako rozwiązanie tego problemu autorzy proponują izolowanie sztucznej inteligencji od zewnętrznych informacji i zasobów wiedzy (zwłaszcza z dziedziny neurofizjologii). Być może wystarczająco inteligentna maszyna mogłaby takie zabezpieczenie obejść – ale czyż nie dowiodłaby wtedy właśnie, że jest inteligentna?

W stronę teorii umysłu

Jest jeszcze jedna cecha mogąca być wyznacznikiem inteligencji i świadomości, którą wśród zwierząt posiedliśmy tylko my, szympansy i (prawdopodobnie) kruki. A raczej należałoby napisać: „istoty lub maszyny”, bowiem od niedawna dysponują nią także komputery.

Umiejętność tę dzieci nabywają dość późno, bo w wieku czterech, pięciu lat. Polega na zdolności przyjęcia perspektywy innej niż własna. Oraz uwzględnieniu tego, że inni są odrębnymi istotami, które mogą posiadać wiedzę różną od naszej. Z tego powodu zdolność do przyjmowania cudzego punktu widzenia nosi nazwę „teorii umysłu”.

Wystarczająco złożona maszyna mogłaby nauczyć się udawać, że świadomość posiada

W 2010 roku udało się tak zaprogramować robota ROVIO, aby oszukiwał inne roboty biorące udział w grze w chowanego. Z pozoru błaha zabawa i drobne osiągnięcie, ale przecież umiejętność wyprowadzenia kogoś w pole wymaga wyobrażenia sobie zasobu wiedzy i procesów myślowych przeciwnika – a więc teorii umysłu właśnie.

W 2013 roku podobna rzecz udała się także humanoidalnemu robotowi iCub. Stworzony przez badaczy z Robot Cognition Laboratory w INSERM (Narodowym Instytucie Zdrowia i Badań Medycznych) w Lyonie dysponował modelem ludzkiej pamięci autobiograficznej. Tak jak ludzka, pamięć robota również była podzielona na dwie „części”: epizodyczną, rejestrującą bieżące wydarzenia, i semantyczną, która rejestruje wzorce i zamienia je na reguły. Taki naturalny, ludzki sposób uczenia się świata doprowadził do tego, że iCub był w stanie na przykład zapamiętać (czy właściwsze nie jest już słowo „zrozumieć”?), że kierunki „lewo” i „prawo” są względne – nie odnoszą się bowiem do niego samego, ale do obiektu, o którym mowa.

Programy jak małpy

Całkiem niedawno udało się natomiast posiąść teorię umysłu programowi autorstwa badaczy Uniwersytetu w Tartu w Estonii. Do jego stworzenia wykorzystali relacje społeczne obowiązujące wśród szympansów. Małpy te żyją w sztywnych hierarchiach i członkowie stada znajdujący się nisko w hierarchii szukają pożywienia tylko wtedy, gdy dominujące w stadzie zwierzę nie jest w stanie tego dostrzec. Albowiem uczta w obecności dominującego osobnika grozi tym, że zabierze on całość dla siebie.

Badacze postanowili stworzyć dwa programy, z których jeden (za pomocą uczenia maszynowego ze wzmocnieniem) nagradzali, gdy zdobył umowne pożywienie poza zasięgiem wzroku drugiego. Po kilkuset tysiącach prób program nauczył się tego, co intuicyjnie potrafią szympansy: unikał pożywienia będącego w zasięgu percepcji drugiego programu.

A może to złudzenie?

Czy to już dowód, że sztuczna inteligencja myśli? Trudno powiedzieć, wszakże nie wiemy do końca, czym jest ludzka inteligencja ani na czym polega nasza samoświadomość. Mamy tylko dość ogólne pojęcie tego, na czym polegają procesy myślowe u człowieka. W psychologii wyróżnia się kilka typów inteligencji, medycyna definiuje kilka rodzajów stanów świadomości (w tym stan „minimalnej świadomości”). Filozofowie spierają się o tak zwany twardy problem świadomości, czyli o to, w jaki sposób nasze mózgi ją wytwarzają – ale też o to, czy świadomość w ogóle istnieje. Bo może jest jedynie złudzeniem?

Hipotezom, że maszyny już teraz potrafią myśleć (przynajmniej na pewnym poziomie) tak jak ludzie, przyglądają się od pół roku badacze z Instytutu Oceny Technologii i Analiz Systemów z Instytutu Technologii w Karlsruhe. Podczas projektu, którego zakończenie planowane jest na koniec 2020 roku, nazwanego „Clarification of Suspicion of Consciousness in Artificial Intelligence” (Wyjaśnienie podejrzeń dotyczących świadomości w zakresie sztucznej inteligencji) chcą zebrać dane, wypracować interdyscyplinarne podejście do tematu i poddać go publicznej dyskusji.

A warto dyskutować, bo test Turinga po ponad pół wieku stracił już swoją moc. Chatbota, z którym można porozmawiać, możesz kupić już za mniej niż dolara.