Poznać emocje człowieka po sposobie, w jaki się porusza? Dla odpowiednio wyszkolonej sztucznej inteligencji to spacerek

„Możesz poznać po tym, jak chodzę, jestem kobieciarzem” – śpiewali Bee Gees w filmie „Gorączka sobotniej nocy”. Czy zorientowałaby się w tym również sztuczna inteligencja? Od premiery hitu z Johnem Travoltą w 1977 roku badania nad nią poczyniły przecież znaczne postępy…

A jeśli koncept „kobieciarza” byłby dla maszyny zbyt mglisty, to może chociaż byłaby w stanie rozpoznać, czy chodzisz „na smutno”, czy „na wesoło”? Z rozpierającą cię energią czy raczej z rezygnacją? A może idziesz wkurzony i zły, mamrocząc przekleństwa pod nosem?

Otóż tego właśnie dowie się na twój temat nowy algorytm sztucznej inteligencji – sposób chodzenia zdradzi mu, jakie emocje odczuwasz.

Kolejny krok SI

Wiadomo, że emocje wpływają na wszystko, co robimy – od głosu, przez mimikę twarzy, na sposobie poruszania się kończąc. Skoro tak, to możliwy jest odwrotny kierunek wnioskowania: z tonu naszego głosu, z wyrazu twarzy, ze sposobu poruszania się można odgadnąć, co czujemy. Znamy już algorytmy, które potrafią przeprowadzić dwa pierwsze wnioskowania. Teraz nadszedł czas na ten ostatni.

Dla człowieka jest to intuicyjne. Czy ktoś dostojnie kroczy czy niechlujnie człapie, czy pędzi uskrzydlony, czy raczej ponuro drepcze w miejscu – widzi w zasadzie każdy obdarzony jakim takim ilorazem inteligencji emocjonalnej. Teraz uczą się tego systemy komputerowe.

Chodzić jak model… 3D

Tanmay Randhavane, Uttaran Bhattacharya, Kyra Kapsaskis, Kurt Gray, Aniket Bera i Dinesh Manocha – naukowcy z Uniwersytetu Karoliny Północnej w Chapel Hill i z Uniwersytetu Marylandu w College Park – wytrenowali system, który posługując się algorytmami głębokiego uczenia, potrafi z 80-procentową poprawnością odgadnąć cztery ludzkie emocje: smutek, radość, złość i obojętność. Wyniki swoich badań opublikowali w czerwcu w czasopiśmie arXiv.

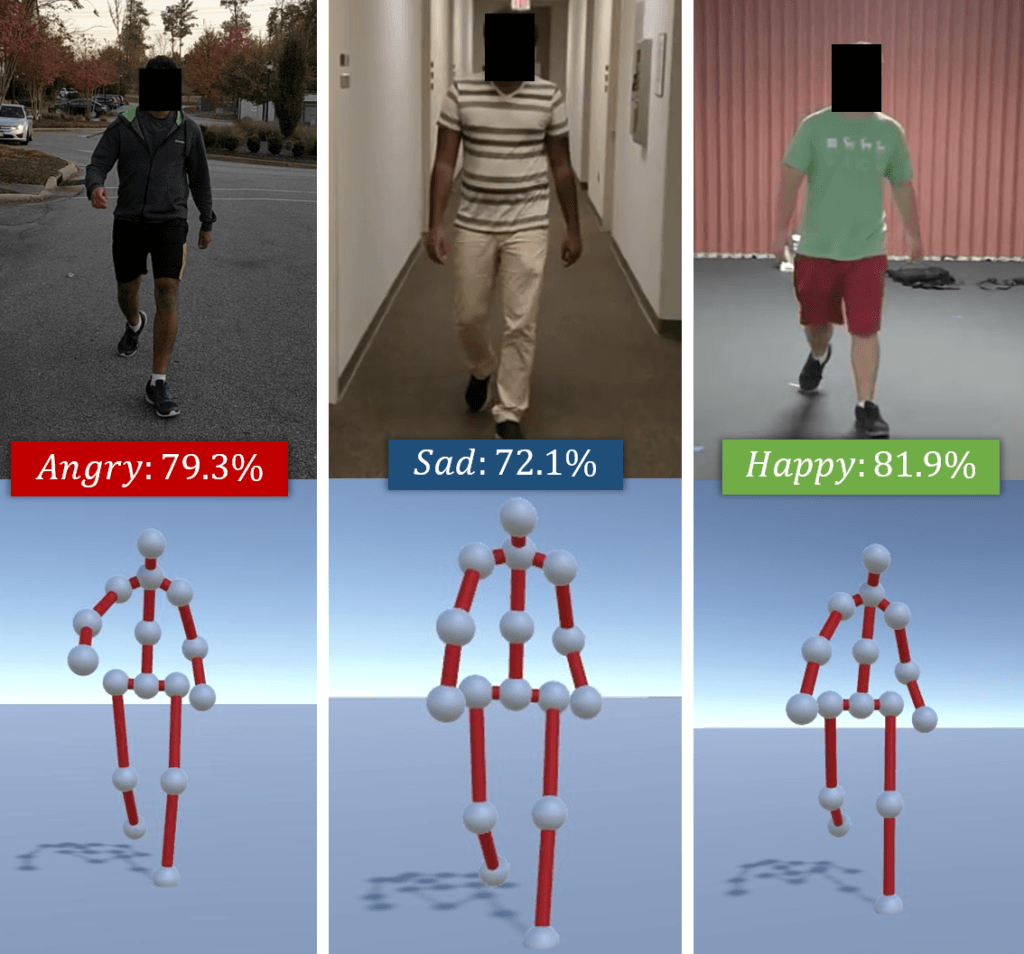

Ich system najpierw analizuje nagranie wideo, na którym widać idące osoby. Następnie przetwarza ich sylwetki w modele 3D i analizuje sam ruch. Określa dominującą u każdego cechę i łączy je z określonymi emocjami.

Co ciekawe, na pierwszy rzut mojego, ludzkiego oka, chód trzech osób, które widzę na obrazku, nie różni się od siebie niemal wcale. Nie ma tu ani radosnych podskoków, ani teatralnie przygiętej nieszczęściem do ziemi sylwetki. A jednak trafiają do trzech innych kategorii – jedna jest smutna, druga wesoła, trzecia zła. Diabeł tkwi więc w szczegółach – w nieco bardziej zamaszystym ruchu rąk czy lekko wydłużonym kroku.

Jak system rozpoznaje emocje?

Najpierw sieć LSTM (sieć krótkiej i długiej pamięci) rozpoznaje cechy charakterystyczne dla każdej emocji na podstawie bazy danych. Następnie są one łączone z cechami charakteryzującymi krok i postawę badanych, a na końcu klasyfikowane za pomocą algorytmu Random Forest. W ten sposób udaje się poprawnie ocenić cztery emocje aż w 80 procentach przypadków. Co więcej, system ocenia także stopień pobudzenia i to, czy emocja jest pozytywna, czy negatywna.

Przy tej okazji powstała EWalk – pierwsza w historii baza danych, która zawiera sklasyfikowane już pod względem emocjonalnym nagrania chodzących ludzi.

Jak nas widzą roboty

Wiadomo, że zrozumienie emocji to podstawa dobrej komunikacji. Komputery i roboty powinny wiedzieć, co czujemy, o ile mają funkcjonować wśród nas. To ważne, zwłaszcza że związek człowiek – komputer ma raczej spore widoki na przyszłość. Roboty i inne urządzenia wyposażone w sztuczną inteligencję są już co prawda wyposażone w systemy rozumiejące mowę, ale pozawerbalne sygnały informujące o naszych emocjach – wyraz twarzy czy mowa ciała – mogą bardzo pomóc w komunikacji.

Inżynierom ta nowa metoda pozwoli tak projektować nowe modele maszyn, żeby ich zachowanie i sposób poruszania się były ze sobą bardziej spójne niż dotychczas. Projektantom gier komputerowych pozwoli tworzyć doskonalsze postaci. A nam – zwykłym zjadaczom chleba – lepiej dogadać się z robotami, od których zapewne w przyszłości roić się będzie świat.

A na razie to istotna informacja dla władzy czy służb porządkowych, które często muszą się liczyć z protestami obywateli, rozmaitymi demonstracjami czy marszami w obronie pewnych wartości lub przeciwko nim. Mając nagranie przemieszczającego się po mieście tłumu, algorytm z łatwością powie nam, czy ci ludzie są weseli, czy spokojni, czy może źli i wściekli.

Zespół naukowców z uniwersytetów Marylandu i Karoliny Północnej szykuje się tymczasem na kolejne wyzwanie: nauczenie maszyn rozumienia emocji, już nie tylko na podstawie chodu, ale także biegu i sposobu gestykulacji.

„Nasze badania są jeszcze na wczesnym etapie – mówi Aniket Bera z uniwersytetu w Chapel Hill w wywiadzie dla serwisu Tech Xplore. – W przyszłości zamierzamy badać kolejne aspekty języka ciała: wyraz twarzy, sposób mówienia, ton głosu, a następnie korelować je ze sposobem, w jaki się poruszamy”.