Jeśli wprowadzimy do programów potencjalnie destrukcyjne czy stronnicze dane, to sztuczna inteligencja będzie destrukcyjna bądź stronnicza. I zatruje nam życie

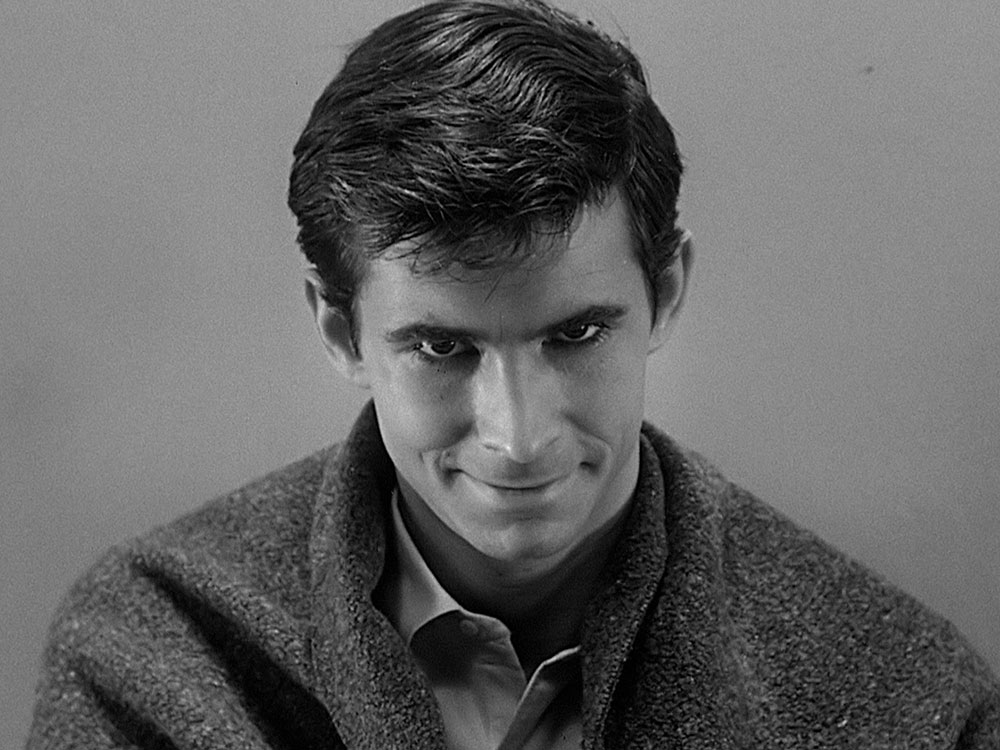

Czy sztuczna inteligencja może być zła? Widocznie tak, skoro Iyad Rahwan, Manuel Cebrian i Pinar Yanardag z Massachusetts Institute of Technology stworzyli pierwszy w dziejach „psychopatyczny” algorytm. Imię odziedziczył po Normanie, bohaterze „Psychozy” Hitchcocka. Norman ma rozpoznawać i podpisywać obrazy. Jednak poddany testowi Rorschacha reaguje tak, że ciarki przechodzą po plecach.

Skłonny do makabry

Próba Rorschacha to jeden z testów psychologicznych. Polega na interpretowaniu amorficznych plam atramentu: w tym samym kształcie jedna osoba widzi np. motyla, druga głowę psa, a trzecia jeszcze coś innego. Psychologowie próbują w ten sposób określić stan umysłu badanego i przekonać się, czy nie ma poważnych zaburzeń psychicznych. Robi wrażenie, choć w psychologii powoli odchodzi się od tej metody. Nie ma bowiem dowodów, że w ten sposób można trafnie prognozować zachowania człowieka.

Tyle że tym razem do testu Rorschacha przystąpili nie ludzie, ale dwie sztuczne inteligencje: cyfrowy psychopata Norman i – dla porównania – druga, „zwykła” SI. Różnice w interpretacji obrazów były szokujące.

Kiedy „zwykła” sztuczna inteligencja widziała na zdjęciu „kilka małych ptaszków na gałęzi”, Norman zobaczył „człowieka porażonego prądem”. Gdy pierwszy algorytm dostrzegł stojącą parę, Norman zinterpretował ten sam obraz jako człowieka wyskakującego przez okno. „Zwykły” algorytm widział wazon z kwiatami, cyberpsychopata – zastrzelonego mężczyznę.

Skąd ta skłonność do makabry?

Złe wychowanie

Norman jest algorytmem, którego zadaniem jest robienie podpisów pod zdjęciami, lecz wyszkolonym wyłącznie na podstawie zdjęć ściągniętych z serwisu internetowego Reddit, z podgrupy, na której publikuje się drastyczne treści: zdjęcia wypadków, katastrof, osób, które zginęły w tragicznych okolicznościach. Swoje „psychiczne skrzywienie” zawdzięcza więc temu, że „wychował się” wyłącznie na obrazach śmierci i zniszczenia.

„Stworzyliśmy Normana, żeby pokazać, jak wielkie znaczenie mają dane, których używamy w procesie uczenia algorytmu – czytamy na stronie projektu. – Kiedy narzekamy na sztuczną inteligencję, pamiętajmy, że to nie sam algorytm jest winien, tylko dane, którymi został >>nakarmiony<<. Ten sam algorytm może postrzegać zupełnie różne rzeczy, także w szalony i niebezpieczny sposób, w zależności od tego, na jakim zestawie danych został wyszkolony”.

Norman wszędzie widzi zło, bo zna tylko zło.

Eksperymenty ze sztuczną inteligencją mają powab tworzenia bytu od zera, wydobywania czegoś z nicości. To trochę jak z narodzinami i wychowywaniem dziecka: algorytmy uczymy w podobny sposób, w jaki uczymy dzieci, więc też możemy je źle „wychować”. Jedyna różnica polega na tym, że w przeciwieństwie do człowieka algorytm nie ma genów, a więc nie dziedziczy żadnych popędów czy uczuć. Algorytm jest tylko programem, który ma wykonać zadanie, do którego został stworzony. A to, jakie to zadanie, zależy już wyłącznie od intencji jego twórców.

Iskierka nadziei

Wniosek? Powinniśmy traktować sztuczną inteligencję tak, jak traktujemy własne dzieci – z pełną odpowiedzialnością za to, czym się stanie. Eksperyment z Normanem przypomina o odpowiedzialności, jaka na nas ciąży. Jeśli wprowadzimy do programów potencjalnie destrukcyjne czy stronnicze dane, to sztuczna inteligencja będzie destrukcyjna bądź stronnicza. I zatruje nam życie.

Eksperymenty ze sztuczną inteligencją mają powab tworzenia bytu od zera, wydobywania czegoś z nicości

Przypadki niepożądanych działań SI są powszechnie znane. Program komputerowy używany do rekrutacji pracowników Amazona dyskryminował kobiety, program stosowany w amerykańskim sądownictwie, oceniający ryzyko popełnienia przestępstwa – czarnoskórych. Nic dziwnego. Ich algorytmy bazowały na danych historycznych, a w przeszłości dyskryminacja kobiety i czarnoskórych była powszechna.

Być może niedługo powstanie nowa dziedzina – psychologia sztucznej inteligencji – i zachowanie maszyn będziemy badać tak samo jak zachowanie człowieka. Na razie musimy jednak pamiętać, że maszyny przejmują poglądy ludzi, którzy je tworzą. Algorytmy mogą mieć wszystkie ludzkie wady, jakie można sobie wyobrazić, bo technologia jest lustrem, w którym się przeglądamy.

Najbardziej niepokojącym pytaniem jest to, kim są twórcy sztucznej inteligencji i jakie mają poglądy. Prof. Rahman uważa, że nie możemy tego procesu pozostawić bez kontroli, że konieczna jest zdecydowanie większa transparentność działań. Czy to realne? Na pewno warto o to walczyć.

Jeśli chodzi o Normana, to jest jeszcze iskierka nadziei. Na stronie projektu każdy może zrobić sobie test Rorschacha, a rezultaty wysłać Normanowi. Być może, jeśli się postaramy, sprawimy, że wyjdzie jeszcze na ludzi?